Durante il Forum ICT Security 2024, la presentazione “Generative AI’s Emerging Disruption of Cybersecurity” di Jim Reavis – Cofondatore e Chief Executive Officer della Cloud Security Alliance (CSA) – ha esplorato il ruolo cruciale dei professionisti della sicurezza informatica nel campo dell’AI generativa.

La discussione ha incluso l’iniziativa in tema di AI security della CSA e i relativi modelli di responsabilità condivisa, evidenziando l’importanza di una comprensione approfondita dell’AI per affrontare nuove minacce e relative opportunità.

Lo stato attuale della Cybersecurity e dell’AI Generativa

In base alla sua esperienza trentennale nel settore della cybersecurity, il relatore ha esordito con la convinzione che attualmente ci si trovi nel mezzo della più grande trasformazione tecnologica mai vista.

L’impatto dell’AI generativa sta già travolgendo le aziende e ne sta ribaltando gli equilibri: come un vulcano, sta facendo tremare la terra sotto di noi.

Di conseguenza i professionisti della sicurezza informatica hanno la responsabilità di conoscere l’AI generativa più di chiunque altro, perché oggi per le organizzazioni è cruciale comprenderne implicazioni ed effetti.

Il ruolo della Cloud Security Alliance

La Cloud Security Alliance è un’organizzazione no-profit con 140 sezioni distribuite in tutto il mondo, che ha costruito una vasta comunità attraverso l’educazione, la ricerca e la condivisione delle migliori pratiche di cybersecurity a livello globale.

La strategia della CSA per l’AI security, lanciata lo scorso anno, tiene in considerazione diverse dimensioni: come l’intelligenza artificiale possa essere attaccata (es. prompt injection, data poisoning), come possa abilitare nuove modalità di attacco e, infine, come possa trasformare i processi di cybersecurity.

Nell’intervento sono quindi stati condivisi esempi concreti di aziende che sperimentano i vari aspetti dell’AI generativa, per ispirare i professionisti della cybersecurity a esplorare simili opportunità nelle loro organizzazioni.

Minacce emergenti con l’AI Generativa

Come ricordato da Reavis nel panorama attuale deepfake, attacchi di phishing sofisticati, social engineering e scansione automatizzata delle vulnerabilità nei grandi repository di GitHub stanno diventando sempre più diffusi.

Le capacità di creare malware polimorfico sono nelle fasi iniziali e, sebbene preoccupanti, appaiono ancora poco sofisticate rispetto a ciò che potrebbe profilarsi nel futuro.

In un futuro non troppo lontano, infatti, si prevede che i cybercriminali potranno sfruttare agenti AI per raccogliere informazioni personali su internet e creare “gemelli digitali” tramite deepfake, riproducendo voci, immagini e comportamenti delle persone prese di mira.

Queste capacità di “clonazione” migliorano di giorno in giorno, rendendo sempre più difficile distinguere tra finzione e realtà: uno dei casi citati ha coinvolto un esperto della CSA che, a scopo sperimentale, ha clonato la propria voce così fedelmente che neppure i suoi figli e amici sono riusciti a distinguerla dall’originale.

Simili tecnologie possono essere utilizzate per attacchi estremamente mirati, ad esempio impersonando qualcuno in una conversazione per richiedere a suo nome denaro o altre transazioni, comportando incredibili cambiamenti nelle capacità offensive.

Comprendere la natura dell’AI Generativa

Reavis ha evidenziato che, nelle conferenze in tema di cybersecurity e AI, sembra che quest’ultima sia spesso vista soltanto come uno strumento per aumentare la produttività.

In realtà l’AI generativa – particolarmente nei large language models – si concentra sulla comprensione delle relazioni tra token, la previsione di sequenze e la generazione di output coerenti. Sebbene ciò possa sembrare innocuo l’evoluzione delle capacità di computazione, unita alla quantità di dati e algoritmi coinvolti, sta creando abilità tanto affascinanti quanto imprevedibili; la natura non deterministica di questi modelli significa che nemmeno i loro creatori possono prevederne le azioni.

L’AI generativa continua infatti a mostrare capacità emergenti, sviluppando nuove abilità in modo inaspettato. Alcuni la paragonano a un bambino o un adolescente: brillante ma privo di coerenza e quindi incline a errori, inesattezze o persino “allucinazioni”.

Verso l’AGI e la necessità di barriere responsabili

Il relatore ha raccontato come un dirigente del settore AI abbia sollecitato la Cloud Security Alliance ad accelerare la sua iniziativa di sicurezza suggerendo che, sulla base dei progressi nel System 2 thinking, l’AI generativa potrebbe presto avvicinarsi all’AGI (Artificial General Intelligence).

Questo dirigente ipotizza infatti che già entro la fine del 2025 i “modelli di frontiera” potrebbero arrivare a padroneggiare la maggior parte delle funzioni svolte dai lavoratori ICT, incluse quelle di cybersecurity. Tale scenario solleva significative preoccupazioni: interagire con l’AI generativa è essenziale per capire come funziona oggi e quali miglioramenti vengono apportati sia nell’addestramento dei modelli e nel miglioramento delle applicazioni, sia nella costruzione di layer di astrazione.

Se vogliamo garantire che un’AI sempre più potente rimanga benefica, è quindi urgente comprendere le implicazioni future e lavorare per creare barriere responsabili.

Il Ruolo dei Professionisti della Cybersecurity

Il relatore ha confermato che gli elementi essenziali della cybersecurity – tra cui la gestione del rischio, delle vulnerabilità e delle identità – continueranno ad essere rilevanti.

Tuttavia, oggi è anche necessario utilizzare l’AI “buona” per combattere quella “cattiva”: i professionisti della sicurezza informatica devono arrivare a comprendere ogni livello di questa tecnologia.

Citando il modello di responsabilità condivisa di Microsoft, ha quindi ricordato come sia necessario implementare una sicurezza olistica per evitare che la responsabilità di garantire la sicurezza ricada solo sugli sviluppatori dei modelli di frontiera, come OpenAI o Google DeepMind. Le organizzazioni che utilizzano questi modelli per creare applicazioni hanno anch’esse responsabilità significative e devono, quindi, garantirne uno sviluppo etico e sicuro.

L’esperienza del cloud computing fornisce un confronto utile: se inizialmente la responsabilità sembrava ricadere solo sugli hyperscaler, nel tempo è diventato chiaro come dovesse essere condivisa tra tutti gli attori coinvolti.

Allo stesso modo, anche il panorama dell’AI generativa richiede un approccio collettivo per la gestione delle relative minacce.

Approcci organizzativi e Gestione del Rischio

Secondo Reavis, l’adozione efficace dell’AI generativa deve includere un approccio organizzativo che definisca chiaramente ruoli, responsabilità e collaborazione tra i dipartimenti. Per quanto la gestione del rischio rimanga centrale, la natura non deterministica dell’AI generativa richiede un approccio differente; il framework di gestione del rischio AI del NIST e le complementari risorse create dalla CSA possono aiutare le aziende ad affrontare queste sfide.

Oggi difendere le organizzazioni impone di concentrarsi maggiormente sulla governance dei dati. Il modello Zero Trust si conferma una strategia efficace per proteggere le informazioni: tuttavia, considerato che quando i dati sono inseriti nei large language models (LLM) i controlli di sicurezza vengono rimossi, è necessario replicarli in modo efficace al loro interno.

La formazione all’interno delle organizzazioni è necessaria per garantire che tutti comprendano gli obiettivi e partecipino alle responsabilità di sicurezza. Per saperne di più, Reavis ha consigliato di visitare la pagina dedicata alla safety initiative della CSA.

L’impatto dell’AI Generativa sulle Organizzazioni

Avviandosi alle conclusioni del suo intervento, il relatore ha ribadito come l’AI generativa stia ridefinendo gli assetti e producendo cambiamenti culturali all’interno delle organizzazioni.

Ha citato al riguardo l’esempio di Caleb Sima, presidente dell’AI Safety Initiative: partendo dai suoi primi contributi allo sviluppo di soluzioni di sicurezza per applicazioni web, Sima ha ricoperto ruoli di leadership nel settore finanziario ma in seguito ha scelto di impegnarsi presso la CSA, mosso da una profonda curiosità per il potere trasformativo dell’AI generativa.

Affrontare le Sfide della Cybersecurity: le “tre C”

Basandosi sulle ricerche svolte da Sima, le ultime slide condivise hanno sintetizzato le principali aree operative che i CISO devono includere per gestire la sicurezza AI: definizione del budget, analisi delle vulnerabilità, reporting, applicazione del principio least privilege, profili di compliance e misurazione, per arrivare alla gestione degli incidenti e relative azioni di risposta.

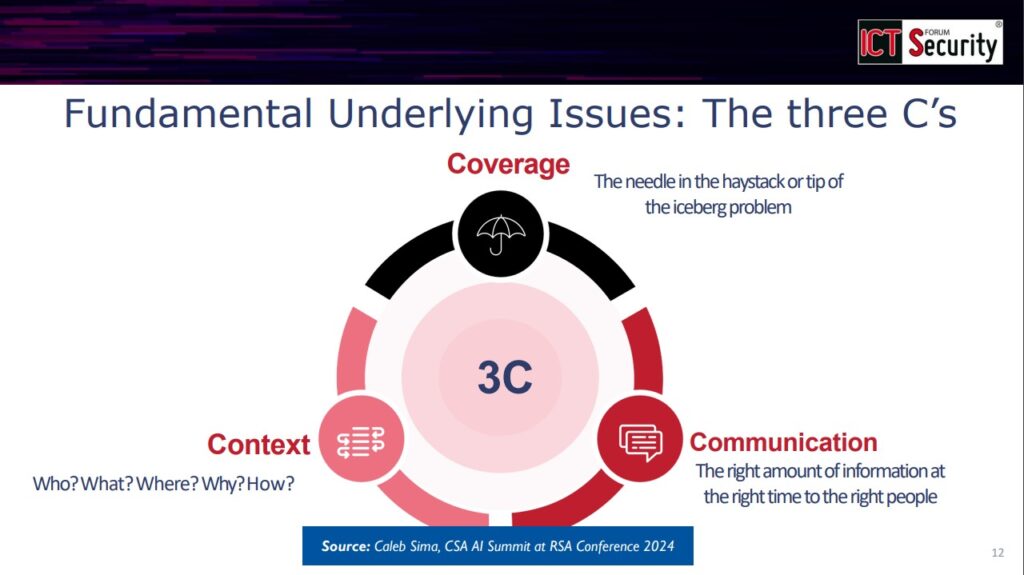

Poiché queste aree sono spesso difficili da gestire, può essere utile riassumerle nelle “tre C”: Contesto, Copertura e Comunicazione.

Comprendere il contesto, infatti, è cruciale per valutare se un determinato indicatore rappresenti una minaccia reale; è poi vitale garantire un’adeguata copertura di tutte le aree del sistema (spesso il triage si basa su presupposti errati proprio a causa di una copertura limitata) nonché attuare una comunicazione efficace (dato che una scarsa comunicazione interna è spesso la principale causa di fallimento delle strategie aziendali).

Sfruttare l’AI Generativa per vincere le Sfide

Tornando all’importanza del contesto, il relatore ha ribadito che l’AI generativa eccelle nell’analizzare grandi quantità di informazioni e fornire approfondimenti utili su più dimensioni.

Ad esempio, valutare un log o una scansione di vulnerabilità potrebbe comportare la riconsiderazione di privilegi o accessi insoliti; il contesto aggiunto da recenti discussioni tra sviluppatori su Slack o Zoom potrebbe aiutare a definire la priorità della risposta ed evitare la classificazione errata di problemi critici.

Al fine di comprendere meglio la loro postura di sicurezza, alcune aziende hanno già iniziato a utilizzare l’AI per integrare nelle proprie analisi dati tratti da verbali delle riunioni, email o altre fonti informali. Questo approccio ha il vantaggio di rendere la cybersecurity più accessibile e coinvolgente anche per chi operi al di fuori dei tradizionali ruoli di sicurezza, rendendo il processo più efficiente e migliorando la qualità generale dei servizi.

Conclusioni

Alla luce di ciò – secondo Reavis – una profonda e responsabile integrazione dell’AI può inaugurare una nuova era di threat intelligence, ottimizzare i flussi di lavoro della cybersecurity e abilitare misure difensive che garantiscano la resilienza dei sistemi a fronte di avversari sempre più sofisticati.

È ormai evidente come l’AI possa supportare le organizzazioni in tutti i domini della sicurezza: analizzare vasti quantitativi di dati non strutturati per identificare i rischi in tempo reale, automatizzare le valutazioni delle vulnerabilità e fornire elementi contestuali per il processo decisionale è infatti cruciale non solo per gestire proattivamente minacce attuali e future, ma anche per evolversi in un paesaggio digitale in rapida trasformazione.

Dopo aver ribadito che l’AI generativa consentirà di tenere il passo delle minacce emergenti, con impatti positivi sull’intero settore, il relatore ha concluso confermando la determinazione della Cloud Security Alliance nel partecipare a questa trasformazione.

https://www.ictsecuritymagazine.com/articoli/ai-generativa-security/