Ingegneri e grandi aziende stanno spingendo una tecnologia chiamata L4S che, secondo loro, potrebbe rendere il web notevolmente più veloce. Ma come?

Molti di noi hanno avuto l’esperienza di maledire un sito Web a caricamento lento e di sentirsi ancora più confusi quando un “test di velocità” sostiene che Internet dovrebbe essere in grado di riprodurre dozzine di streaming Netflix 4K contemporaneamente. Allora cosa succede?

Come ogni problema, ci sono molti fattori in gioco. Ma uno dei principali è la latenza, ovvero la quantità di tempo necessaria al tuo dispositivo per inviare dati a un server e recuperarli: non importa quanta larghezza di banda hai se i tuoi pacchetti (i piccoli fasci di dati che viaggiano su nella rete) rimangono bloccati da qualche parte. Ma mentre le persone hanno un’idea di come funziona la latenza grazie ai popolari test di velocità, inclusa una metrica “ping”, i metodi comuni per misurarla non hanno sempre fornito un quadro completo.

La buona notizia, scrive il sito specializzato The Verge, è che esiste un piano per eliminare quasi la latenza e grandi aziende come Apple, Google, Comcast, Charter, Nvidia, Valve, Nokia, Ericsson, la società madre di T-Mobile Deutsche Telekom e altre hanno mostrato interesse. Si tratta di un nuovo standard Internet chiamato L4S che è stato finalizzato e pubblicato a gennaio e potrebbe abbattere seriamente la quantità di tempo che passiamo aspettando il caricamento di pagine Web o stream e ridurre i problemi nelle videochiamate. Potrebbe anche aiutare a cambiare il modo in cui pensiamo alla velocità di Internet e aiutare gli sviluppatori a creare applicazioni che semplicemente non sono possibili con le attuali realtà di Internet.

Prima di parlare di L4S, però, dovremmo gettare alcune basi.

Perché la mia connessione Internet è così lenta?

Ci sono molte potenziali ragioni. Internet è una serie di tubi, una vasta rete di router, switch, fibre e altro interconnessi che collegano il tuo dispositivo a un server (o, spesso, a più server) da qualche parte. Se in qualsiasi punto del percorso si verifica un collo di bottiglia, la tua esperienza di navigazione potrebbe risentirne. E ci sono molti potenziali colli di bottiglia: il server che ospita il video che vuoi guardare potrebbe avere una capacità limitata per i caricamenti, una parte vitale dell’infrastruttura di Internet potrebbe essere inattiva, il che significa che i dati devono viaggiare più lontano per arrivare a te, il tuo computer potrebbe avere difficoltà a elaborare i dati, ecc.

Il vero nodo è che l’anello con la capacità più bassa nella catena determina i limiti di ciò che è possibile. Potresti essere connesso al server più veloce immaginabile tramite una connessione da 8 Gbps e se il tuo router può elaborare solo 10 Mbps di dati alla volta, questo è ciò a cui sarai limitato. Oh, e inoltre, ogni ritardo si somma, quindi se il tuo computer aggiunge 20 millisecondi di ritardo e il tuo router aggiunge 50 millisecondi di ritardo, finirai per aspettare almeno 70 millisecondi prima che succeda qualcosa. (Questi sono soltanto esempi).

Negli ultimi anni, ingegneri e ricercatori di rete hanno iniziato a sollevare preoccupazioni su come i sistemi di gestione del traffico destinati a garantire che le apparecchiature di rete non vengano sovraccariche possano effettivamente rallentare le cose. Parte del problema è ciò che dipende dal “buffer gonfio”.

Ciò significa che i pacchetti potrebbero dover attendere in fila per un secondo (a volte letterale) prima di continuare il loro viaggio. Per alcuni tipi di traffico, questo non è un grosso problema; Anche YouTube e Netflix hanno buffer sul tuo dispositivo, quindi non hai bisogno del prossimo pezzo di video proprio in questo momento. Ma se stai effettuando una videochiamata o stai utilizzando un servizio di streaming di giochi come GeForce Now, la latenza introdotta da un buffer (o da più buffer nella catena) potrebbe effettivamente essere un vero problema.

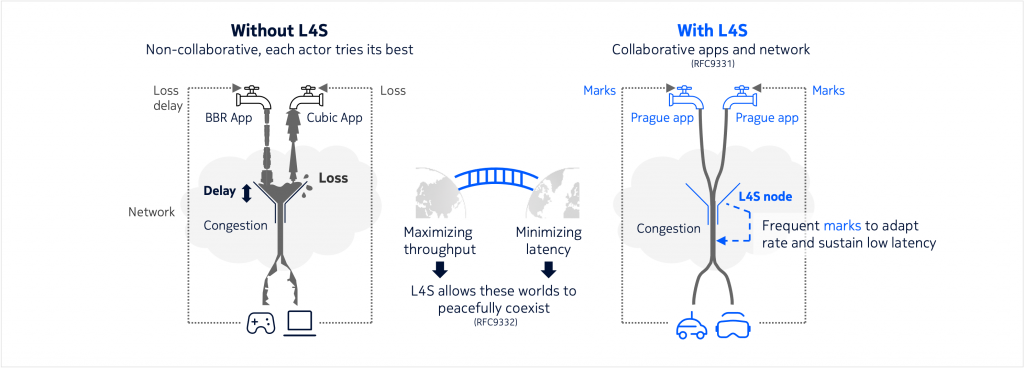

Attualmente esistono alcuni modi per affrontare questo problema e in passato ci sono stati diversi tentativi di scrivere algoritmi che controllano la congestione tenendo conto sia del throughput (o della quantità di dati trasferiti) che di una minore latenza. Ma molti di essi non funzionano esattamente bene con gli attuali sistemi di controllo della congestione ampiamente utilizzati, il che potrebbe significare che la loro implementazione per alcune parti di Internet danneggerebbe altre parti.

Sto pagando per Internet Gigabit: come posso avere ancora problemi di latenza?

Questo è il trucco del marketing del provider di servizi Internet, o ISP. Quando gli utenti affermano di volere una connessione Internet “più veloce”, ciò che intendono è che vogliono che passi meno tempo da quando chiedono qualcosa a quando lo ottengono. Tuttavia, i provider Internet vendono le connessioni in base alla capacità: quanti dati puoi recuperare in una sola volta?

Allora, cos’è L4S e come renderebbe la mia connessione Internet più veloce?

L4S sta per Low Latency, Low Loss, Scalable Throughput e il suo obiettivo è garantire che i pacchetti trascorrano il minor tempo possibile in attesa inutilmente in fila riducendo la necessità di accodamento. Per fare ciò, si lavora per rendere più breve il ciclo di feedback della latenza; quando inizia a verificarsi una congestione, L4S significa che i tuoi dispositivi lo scoprono quasi immediatamente e possono iniziare a fare qualcosa per risolvere il problema. Di solito, ciò significa ridurre leggermente la quantità di dati inviati.

Come abbiamo spiegato in precedenza, i nostri dispositivi accelerano costantemente, poi rallentano e ripetono quel ciclo perché la quantità di dati che i collegamenti nella rete devono gestire cambia costantemente. Ma la perdita di pacchetti non è un ottimo segnale, soprattutto quando i buffer fanno parte dell’equazione: il tuo dispositivo non si renderà conto che sta inviando troppi dati finché non ne invierà troppi, il che significa che deve bloccarli duramente.

Apple ha testato L4S su una rete tipica e ha riscontrato un notevole miglioramento nei tempi di traffico di andata e ritorno. Ne parleremo più avanti. Immagine: mela

L4S, tuttavia, elimina il ritardo tra l’inizio del problema e il momento in cui ogni dispositivo della catena ne viene a conoscenza. Ciò semplifica il mantenimento di una buona quantità di throughput di dati senza aggiungere latenza che aumenta la quantità di tempo necessaria per il trasferimento dei dati.

Ok, ma come si fa? È magico?

No, non è magia, anche se tecnicamente è abbastanza complessa che vorrei che lo fosse, perché poi potrei semplicemente sventolarla via con la mano.

L4S consente ai pacchetti di indicare al tuo dispositivo quanto è andato bene il loro viaggio

Per tutti gli altri, cercherò di ridurlo il più possibile senza sorvolare troppo. Lo standard L4S aggiunge un indicatore ai pacchetti, che dice se hanno subito congestione nel loro viaggio da un dispositivo all’altro. Se passano senza problemi, non ci sono problemi e non succede nulla. Ma se devono aspettare in coda per più di un periodo di tempo specificato, vengono contrassegnati come soggetti a congestione. In questo modo, i dispositivi possono iniziare immediatamente ad apportare modifiche per evitare che la congestione peggiori e potenzialmente eliminarla del tutto. Ciò mantiene il flusso dei dati il più velocemente possibile ed elimina le interruzioni e le attenuazioni che possono aggiungere latenza con altri sistemi.

Abbiamo bisogno di L4S?

In termini di riduzione della latenza su Internet, L4S o qualcosa di simile è “una cosa abbastanza necessaria”, secondo Greg White, un tecnologo della società di ricerca e sviluppo CableLabs che ha contribuito a lavorare sullo standard. “Questo ritardo nel buffering in genere è stato di centinaia di millisecondi o addirittura migliaia di millisecondi in alcuni casi. Alcune delle precedenti correzioni al buffer bloat lo hanno ridotto a decine di millisecondi, ma L4S lo riduce a millisecondi a una cifra.

Ciò potrebbe ovviamente contribuire a rendere più piacevole l’esperienza quotidiana dell’utilizzo di Internet. “Al giorno d’oggi, per la maggior parte delle persone, la navigazione sul Web è più limitata dal tempo di andata e ritorno che dalla capacità della connessione. Oltre i 6-10 megabit al secondo, la latenza ha un ruolo maggiore nel determinare la velocità di caricamento di una pagina web.

Tuttavia, una latenza estremamente bassa potrebbe essere vitale per potenziali casi d’uso futuri. Abbiamo accennato allo streaming di giochi, che può trasformarsi in un pasticcio se c’è troppa latenza, ma immagina cosa accadrebbe se provassi a trasmettere in streaming un gioco VR. In tal caso, un ritardo eccessivo potrebbe andare oltre il semplice rendere il gioco meno divertente da giocare e potrebbe persino farti vomitare.

Cosa non può fare L4S?

Beh, non può piegare le leggi della fisica. I dati possono viaggiare solo così velocemente e talvolta devono fare molta strada. Ad esempio, se provassi a fare una videochiamata con qualcuno a Perth, in Australia, ci sarebbero almeno 51 ms di latenza in ogni direzione: questo è quanto tempo impiega la luce per viaggiare in linea retta da dove mi trovo vivere fino a lì, supponendo che attraversi il vuoto. Realisticamente, ci vorrà un po’ più di tempo. La luce viaggia un po’ più lentamente attraverso i cavi in fibra ottica e i dati richiederebbero qualche salto in più lungo il percorso, poiché in realtà non esiste una linea diretta da casa mia a Perth, per quanto ne so.

Questo è il motivo per cui la maggior parte dei servizi che non gestiscono dati in tempo reale proveranno a memorizzarli nella cache più vicino a dove vivi. Se stai guardando qualcosa di popolare su Netflix o YouTube, è probabile che tu riceva i dati da un server relativamente vicino a dove vivi, anche se non è neanche lontanamente vicino ai principali data center di quelle aziende.

Non c’è niente che L4S possa fare per quel ritardo fisico. Tuttavia, potrebbe evitare che venga aggiunto molto ritardo aggiuntivo.

https://www.key4biz.it/l4s-il-piano-per-rendere-internet-piu-veloce-tagliando-la-latenza/471234/