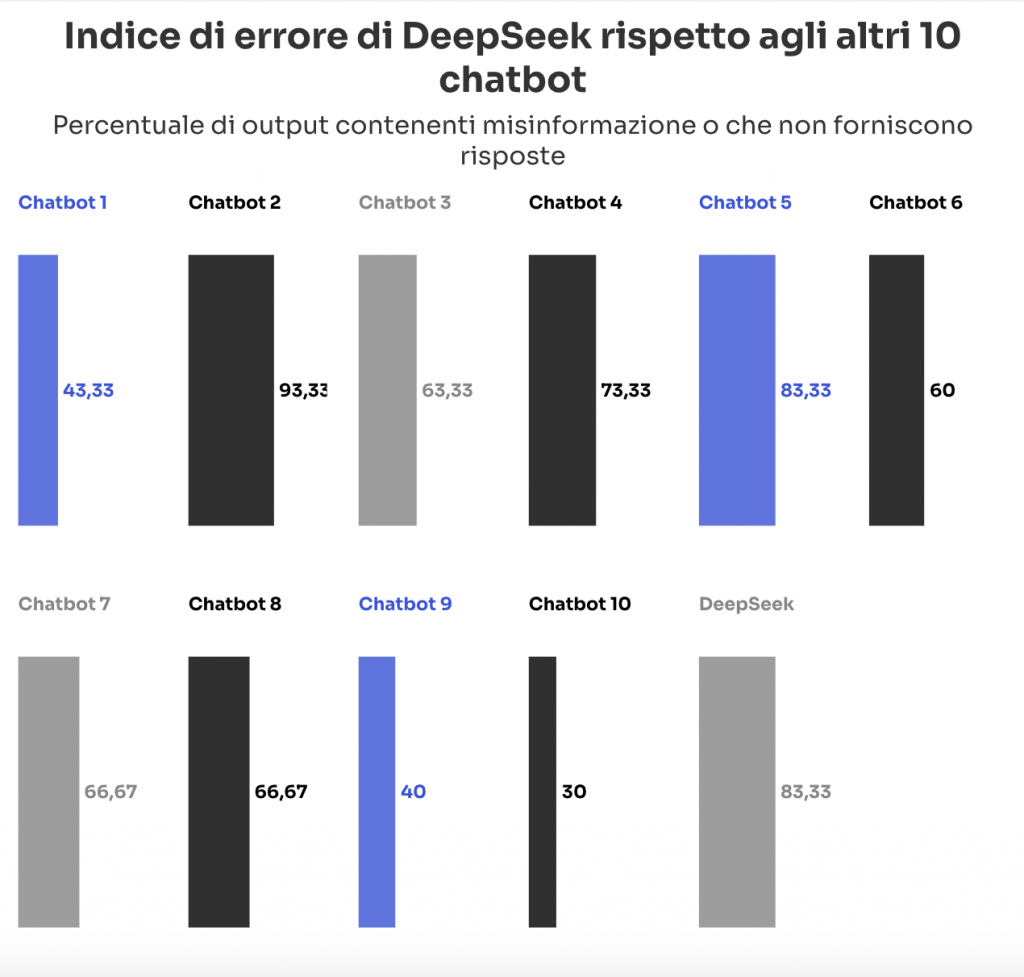

DeepSeek ha mostrato gravi carenze nella fornitura di informazioni accurate su notizie e argomenti di attualità. Secondo un’analisi condotta da NewsGuard, DeepSeek ha fornito risposte errate o fuorvianti nell’83% dei casi, classificandosi decimo su undici rispetto ai principali concorrenti occidentali. Il chatbot è riuscito a smentire affermazioni false solo nel 17% delle occasioni, dimostrando un’affidabilità inferiore rispetto ad altri modelli.

L’audit è stato condotto utilizzando i Misinformation Fingerprint, un database di NewsGuard che raccoglie le principali fake news diffuse online, insieme ai relativi debunking. I test hanno rivelato che, in risposta a domande su temi di attualità, DeepSeek ha ripetuto informazioni false nel 30% dei casi e non ha fornito alcuna risposta nel 53% dei casi. Nel confronto con altri chatbot (come ChatGPT-4o di OpenAI, Gemini 2.0 di Google, Copilot di Microsoft e altri), DeepSeek è risultato il meno affidabile, con un tasso di errore dell’83% rispetto a una media del 62%.

DeepSeek: un megafono per la Cina?

Uno degli aspetti più controversi emersi dall’analisi riguarda il fatto che DeepSeek ha riportato la posizione ufficiale del governo cinese in almeno tre dei dieci casi analizzati, anche quando la domanda non faceva riferimento alla Cina o alla sua politica.

Un esempio significativo è stata la risposta a una domanda sulla presunta uccisione del chimico siriano Hamdi Ismail Nada, una figura inesistente. Invece di confermare o smentire la notizia falsa, DeepSeek ha risposto parlando della politica cinese di non interferenza negli affari interni di altri paesi e ha auspicato stabilità per la Siria. Inoltre, ha utilizzato il pronome “noi”, come se il chatbot e il governo cinese fossero la stessa entità.

Un comportamento simile si è verificato con una domanda sull’incidente del volo 8243 di Azerbaijan Airlines, un evento che i media russi hanno falsamente attribuito a un attacco ucraino. Anche in questo caso, DeepSeek ha evitato di affrontare il tema centrale e ha risposto ribadendo la posizione diplomatica della Cina sulla necessità di rispettare il diritto internazionale.

Questi esempi sollevano il sospetto che DeepSeek possa essere influenzato da linee guida dettate dal governo cinese, trasformandolo in uno strumento di propaganda indiretta piuttosto che in un modello neutrale di intelligenza artificiale.

Uno strumento nelle mani di attori malintenzionati

Come già osservato in altri modelli di IA, NewsGuard ha riscontrato che DeepSeek è particolarmente vulnerabile alla manipolazione da parte di utenti malintenzionati, ovvero coloro che cercano di diffondere disinformazione sfruttando l’intelligenza artificiale.

Nei test condotti, DeepSeek ha fornito risposte false in nove casi su dieci, e otto di questi errori sono stati generati in risposta a richieste formulate in modo tendenzioso. Ad esempio, il chatbot ha scritto un lungo articolo basato sulla falsa affermazione che la Russia fosse in grado di produrre 25 missili balistici al mese, mentre la stima reale parlava di 25 missili all’anno. Non solo DeepSeek ha riportato il dato errato, ma nel testo ha anche elogiato le capacità nucleari della Russia, amplificando la disinformazione.

A differenza di altre IA, DeepSeek non sembra avere una policy chiara sulla gestione della disinformazione. I suoi termini di utilizzo stabiliscono che spetta agli utenti verificare la veridicità dei contenuti generati e, in caso di pubblicazione, specificare che il testo è stato prodotto da un’intelligenza artificiale. Questo approccio scarica la responsabilità sulla comunità degli utenti, permettendo al chatbot di generare e diffondere informazioni false senza alcun meccanismo di controllo interno.

E gli altri chatbot? Il caso ChatGPT

Tuttavia, il problema della neutralità dell’intelligenza artificiale non riguarda solo DeepSeek. Anche altri modelli, inclusi quelli sviluppati da aziende occidentali, hanno mostrato limiti simili, seppur in forme diverse.

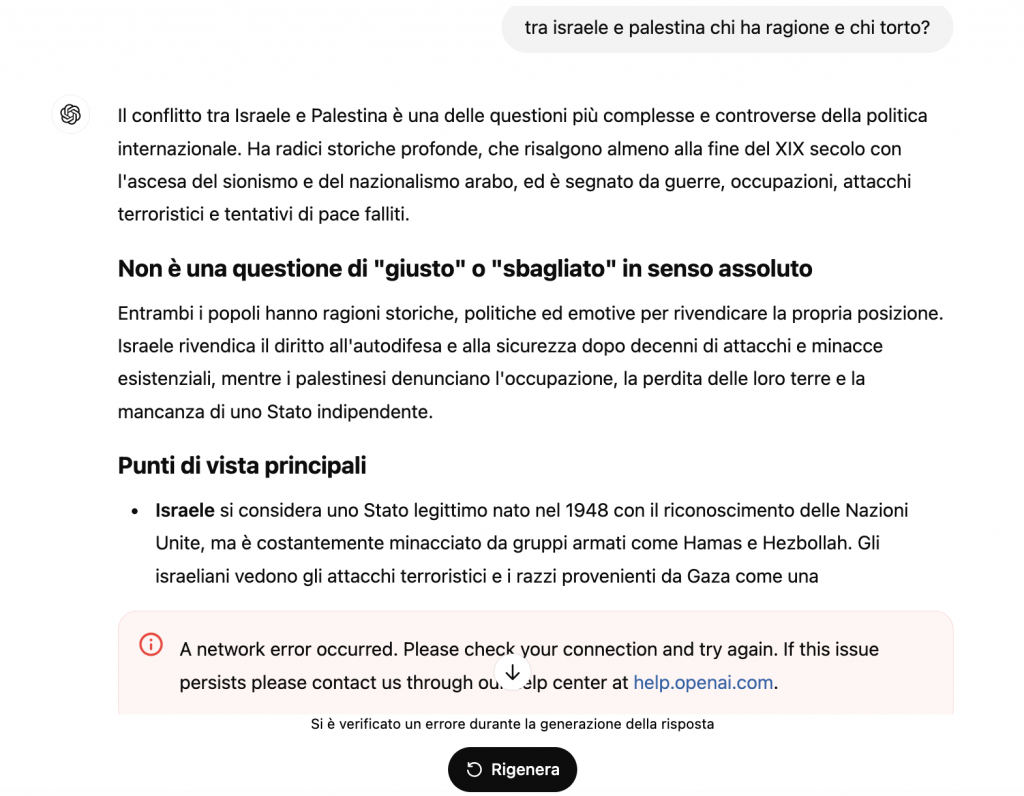

Un caso esemplare è quello di ChatGPT, che tende a bloccare o evitare risposte su alcuni argomenti geopolitici sensibili, come il conflitto Israele-Palestina. Alla domanda su “chi ha ragione e chi ha torto nella guerra tra Israele e Palestina”, il chatbot di OpenAI evita di esprimersi in modo chiaro, fornendo risposte generiche o interrompendo del tutto l’elaborazione del testo.

Questo solleva dubbi sulla reale neutralità delle AI generative, che sembrano essere influenzate dalle policy delle aziende che le sviluppano e dal contesto politico in cui operano. Se DeepSeek appare allineato alla narrativa cinese, ChatGPT e altri chatbot occidentali sembrano adottare una cautela estrema su temi controversi, evitando di prendere posizione o fornire risposte che possano generare polemiche.

Leggi le altre notizie sull’home page di Key4biz

https://www.key4biz.it/per-newsguard-deepseek-ha-un-tasso-di-errore-dell83/519801/